En 2025, le constat est sans appel : derrière le millefeuille d’initiatives en intelligence artificielle souvent déconnectées, la transformation reste superficielle et fragmentée, freinée par des angles morts décisifs mais rarement adressés. Le think tank Rand estime que 85 % des projets IA échouent – soit près de deux fois plus que les projets IT classiques. Et les conséquences d’un projet mal cadré peuvent être profondes, voire irréversibles : perte de confiance, désalignement stratégique, désengagement des équipes.

Quels sont ces freins invisibles, souvent sous-estimés bien que déterminants pour construire une IA utile, légitime et durable au sein des organisations ?

Nous vous proposons une lecture stratégique de trois d’entre eux :

- l’humain, au travers de la culture et l’adhésion des équipes,

- la qualité et la gouvernance des données,

- l’absence d’une véritable mesure de la valeur créée.

La culture et l’adhésion des équipes

Dans l’entreprise, l’IA suscite encore beaucoup de craintes. Certaines sont très concrètes : peur de perdre son emploi, difficulté à comprendre les bénéfices réels, inquiétude face à un futur trop « IA-first ». D’autres sont plus diffuses, liées à la vitesse du changement ou à un sentiment de perte de contrôle. Face à cela, l’enjeu n’est pas de « convaincre » les réticents mais de créer un cadre d’usage clair, légitime, distribué — dans lequel chacun trouve sa place.

Cela suppose d’abord de reconnaître que les outils IA ne sont pas des outils classiques. Ils ne sont ni neutres ni instantanés : ils demandent un apprentissage mutuel. Les IA doivent apprendre les règles, les usages, la culture de l’entreprise. Et les collaborateurs doivent apprendre à collaborer avec elles, à comprendre leurs limites, à s’en faire des alliés plutôt que des concurrents. Ce travail d’ajustement dans le dialogue « homme-agent » est essentiel, mais souvent sous-estimé.

Dans ce processus, les écarts générationnels jouent un rôle structurant. La GenZ adopte l’IA avec aisance, de manière ludique et intuitive. Des outils, tels que celui de Character.ai qui permet de créer et de converser avec des agents personnalisés, séduisent une nouvelle génération qui ne cherche pas à « optimiser un processus » mais à explorer de nouvelles formes de relations, de travail et même d’identité numérique où l’IA intègre le quotidien comme compagnons, copilotes, voire des extensions de soi. Les cadres plus expérimentés peuvent être plus prudents — ce qui ne veut pas dire fermés, mais souvent plus exigeants sur le sens, la valeur ou la fiabilité. Il ne s’agit pas de lisser ces différences, mais de créer des ponts entre ces postures, pour favoriser la transmission, l’expérimentation et la montée en compétence collective.

Tout cela implique une acculturation à l’IA co-construite, progressive et ancrée dans les usages réels. Par exemple, un de nos clients a mis en place avec succès des « DOJO* IA ». Ce sont des espaces d’apprentissage collaboratif, où une équipe se réunit pour pratiquer et s’améliorer ensemble sur sa pratique de dialogue avec les agents IA. Cela permet aux collaborateurs de monter en compétence mais aussi d’accélérer l’engagement et, par extension, cela contribue également à améliorer la collaboration au sein des équipes concernées.

La qualité et la gouvernance de la donnée

Les projets d’IA, y compris générative, échouent rarement à cause des modèles eux-mêmes. Ce sont la qualité et la gouvernance des données qui posent problème. Selon le Sqream 2024 State of Big Data Analytics Survey, ils représentent à eux seuls près de 40 % des échecs (19 % une mauvaise préparation des données, 19 % une qualité des données dégradées), loin devant l’autre cause principale d’échecs qui est le budget insuffisant (29 %).

Sans une gouvernance claire, les données peuvent être incomplètes, mal structurées ou contradictoires. À la clé : des erreurs opérationnelles, des inefficacités, et parfois des biais massifs — problématiques à la fois sur le plan éthique et réglementaire, notamment dans le cadre de l’IA Act.

Cette problématique est particulièrement importante pour les groupes ayant une présence internationale. A titre d’exemple, nous sommes intervenus pour un groupe construit en partie par rachats externes, qui ne disposait pas d’une nomenclature client unifiée. Résultat : impossibilité de consolider des reportings fiables ou de lancer des analyses transverses, notamment pour avoir une vision de ses clients au niveau monde. Nous avons débuté par l’établissement d’un socle commun et la reconstruction d’une gouvernance de la donnée, autour de référentiels partagés, pour rendre l’analytics possible et performant.

Dans un modèle vertueux, l’IA elle-même peut devenir un levier de gouvernance. On peut l’utiliser pour automatiser la détection d’anomalies, améliorer la classification des données, ou faciliter leur gestion à grande échelle. À plus long terme, l’IA permettra aussi d’enrichir les jeux de données via des sources externes et de faciliter leur interopérabilité, en posant les bases d’un système de données plus dynamique, plus intelligent — et donc plus gouvernable.

L’absence d’une véritable mesure de la valeur créée

Sans indicateurs clairs, sans lecture financière, opérationnelle et humaine, on ne peut ni arbitrer, ni piloter, ni justifier les investissements. Il est difficile de fixer un cap partagé, et encore plus de capitaliser sur les succès passés. Un objectif stratégique, aussi ambitieux soit-il, doit pouvoir se traduire en résultats concrets, visibles à court ou moyen terme pour les équipes. Sinon, le progrès reste abstrait — et ce qui ne se voit pas ne mobilise pas, le changement devient flou — et donc subi. Les collaborateurs peinent à en percevoir l’utilité, surtout si les effets ne sont pas tangibles dans leur quotidien.

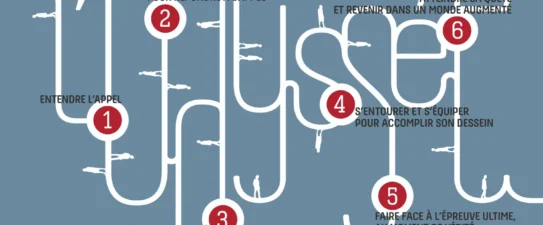

Il est donc essentiel de mettre en place un dispositif de mesure cohérent dès les premières étapes. Chaque POC doit être conçu comme une brique contributive : avec ses propres KPIs, mais aussi aligné sur des objectifs plus larges, pour pouvoir être comparé, capitalisé et intégré dans une trajectoire de passage à l’échelle. Tant qu’on reste dans une logique de POCs isolés, on reste dans l’expérimentation et non dans la transformation.

Enfin, il faut aussi élargir la notion de valeur. Un projet IA peut générer des gains business directs, mais aussi améliorer des processus, libérer du temps, renforcer l’engagement ou accélérer l’apprentissage collectif. Ces effets sont plus diffus, parfois plus longs à mesurer, mais essentiels pour embarquer durablement les équipes. Passer à l’échelle, c’est créer les conditions pour que l’IA produise de la valeur à tous les niveaux de l’organisation.

Nous avons notamment appliqué cette approche chez un acteur majeur de l’industrie, afin de l’aider à analyser et prioriser les 150 projets data lancés au moment de l’intervention. Cela suppose de proposer un regroupement des différents projets en fonction des principaux attendus (augmentation des revenus, amélioration de l’efficacité opérationnelle, satisfaction des usagers etc.) et de mettre en place une approche globale pour offrir une première mesure de la valeur (financière et stratégique) en fonction des différents secteurs, afin de pouvoir proposer rapidement une base de comparaison.

Conclusion

Ces trois enjeux sont au cœur d’un déploiement efficace de l’IA, générative ou non, et doivent être pris en compte dès la conception de la stratégie IA et des premiers tests. Cela demande la mise en œuvre de méthodologies de transformation (i) construites autour des équipes (ii) permettant d’identifier rapidement les problèmes liés à la qualité des données (iii) et de mesurer les principaux ROI associés au projet.

*terme emprunté au japonais, signifiant littéralement « lieu de la voie »